手机AI芯片走过8年,为何仍难以发挥最大效能?

本文探讨了手机AI芯片(NPU)的发展历程、现状及未来趋势,分析了LiteRT工具如何统一支持不同厂商NPU,为端侧AI生态带来转机。

八年前,我们首次接触到手机中的神经网络处理器(NPU),还记得2017年华为Mate10搭载的麒麟970吗?这款芯片虽不敌苹果A11和骁龙835,却开创了移动SoC集成NPU的先河。自此,'手机本地也能运行AI'成为可能。

八年时间,苹果和三星陆续加入端侧AI阵营,效果参差不齐;谷歌则将数据中心的张量处理器(TPU)理念融入Tensor芯片。如今,从ARM到高通,各大科技公司都在强调'AI是智能手机未来的核心'。

然而实际应用中,移动AI表现仍显不足:本地AI功能多集中于语音助手、拍照优化、即时翻译等基础场景,开发者创新受限。这种现状部分归因于NPU未充分开放给开发者作为平台使用,令人不禁质疑:NPU究竟具备哪些独特价值?

深度解析:NPU究竟有何特殊性?

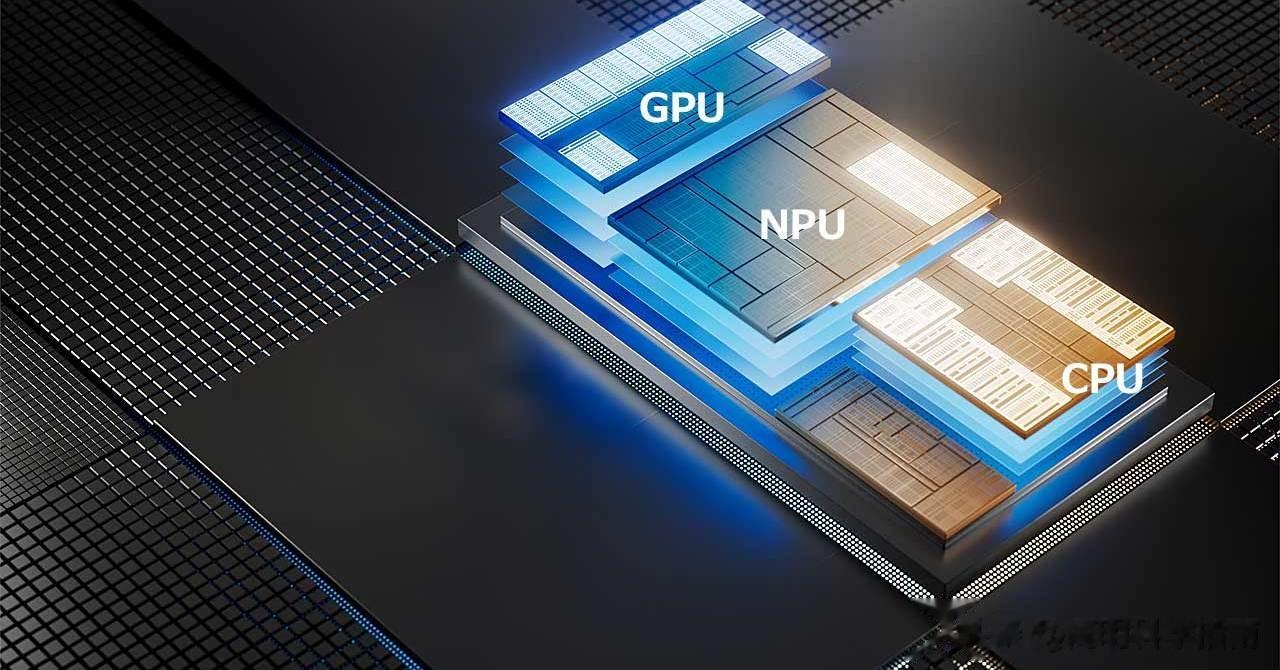

如同负责运行应用的CPU、处理图形的GPU、管理影像的ISP,NPU作为专用计算单元,专为AI任务设计,追求高效与低功耗。如今不仅手机芯片,英特尔和AMD的移动处理器也集成专用NPU,功能侧重各有不同。

具体而言,NPU擅长处理小体量数据(如4位甚至2位精简模型)、特殊内存模式及复杂数学运算(如融合乘加等)。移动NPU流行正是因为传统处理器处理AI任务效率低、耗电大,而NPU能更高效完成。

早在2017年NPU初现时就存在争议:简单算法CPU也能应对,数据中心用的英伟达显卡与手机NPU本质不同。但专用NPU能流畅运行CPU、GPU不擅长的模型,且通常更省电。这种分工虽增加芯片设计复杂度,却能在性能与耗电间取得平衡,这对手机至关重要。

为何AI不优先在显卡上运行?

关注内存涨价的用户了解,AI数据中心特别依赖高性能显卡(尤其是英伟达)和大容量显存。单台AI服务器需配置8张H200算力卡,整合显存达1.2TB,配合最高8TB系统内存,满足高负载计算需求,这就是内存紧缺、价格上涨的主因。

英伟达CUDA架构能高效处理AI和图形任务,核心在于其大规模并行计算和资源调度能力。张量核心可处理各种数据格式的复杂数学运算。

然而移动设备AI仍面临挑战:不同厂商NPU不兼容问题。谷歌2024年推出的LiteRT(Tensor Flow Lite升级组件)可统一支持CPU、GPU及高通、联发科NPU,运行时自动选择最优硬件加速方案,解决NNAPI接口统一但效果差异大的缺陷。

LiteRT不仅适用于Android和iOS,还可用于嵌入式设备和桌面电脑,全程在设备本地运行AI推理。其精度和精简方式预设固定,确保在资源有限的手机设备上稳定运行。

虽然LiteRT解决了兼容性问题,但技术发展可能改变NPU地位。ARM最新C1系列CPU增加SME2扩展指令,部分AI任务提速4倍;手机GPU架构可能升级,更适合AI运算。三星正在研发AI优化GPU,或将在Galaxy S28系列应用;Imagination E系列GPU支持FP8和INT8精度,可能用于Pixel系列。

LiteRT可配合这些技术进步,开发者无需担心硬件变化。CPU对复杂指令支持增强,AI运算效率提升;优化更好的GPU或取代NPU成为默认AI加速器,这些变化LiteRT都能应对。某种程度上,LiteRT犹如移动端的'CUDA',抹平硬件差异,让开发者无需纠结。

NPU不会消失,但AI生态终于有转机

专用移动NPU短期内不会消失,但最初'围绕NPU展开、受厂商限制'的端侧AI模式显然不是最终形态。对于大多数第三方应用,CPU和GPU仍承担主要AI任务,尤其它们对AI运算支持日益增强。

如果LiteRT能成功,开发者将摆脱对某家芯片厂商路线图的依赖,也能开发端侧AI应用。尽管如此,设备端AI要构建充满活力的第三方生态,仍需一段路程。但我们现在已朝着这个方向迈出重要一步。

本文链接:/article/article-66361c51

转载请注明出处,谢谢!